Autor:AXYZ DESIGN

Datum:2023-09-20

ERFORSCHUNG DER AUSWIRKUNGEN VON KI

VERÄNDERT KI DIE ARBEITSABLÄUFE BEI DER ARCHITEKTURVISUALISIERUNG?

INTERVIEW MIT FRANCESCO TESTA VON PROMPT

Bild erstellt von Prompt Studio mit Midjourney AI.

Jeden Tag erleben wir bemerkenswerte Fortschritte auf dem Gebiet der künstlichen Intelligenz mit immer beeindruckenderen Lösungen, die manchmal Bewunderung hervorrufen und manchmal Anlass zur Sorge geben.

Bei AXYZ als Softwareentwickler und bei Ihnen als Künstler stellt sich natürlich die Frage, wie wir diese neuen Technologien optimal nutzen können. Auf welche Weise könnten sie unsere täglichen Aufgaben bereichern? Könnten diese Technologien dazu beitragen, unser Image und unsere Produkte zu verbessern? Und sind sie letztendlich für jedermann zugänglich?

Um diese Fragen zu klären, hatten wir die Ehre, Francesco Testa, den Gründer und kreativen Kopf hinter dem katalanischen Studio Prompt, zu interviewen. Dieses Kreativstudio ist weithin für seine Fähigkeit bekannt, Architekturprojekte durch fesselnde Visualisierungen, Animationen und virtuelle 360°-Rundgänge zum Leben zu erwecken.

Bevor wir fortfahren, möchte ich Ihnen unseren aufrichtigen Dank dafür aussprechen, dass Sie uns die wertvolle Gelegenheit gegeben haben, tiefer in die Projekte und Arbeiten Ihres Studios einzutauchen. Darüber hinaus freuen wir uns, dass Sie sich bereit erklärt haben, an diesem Kurzinterview teilzunehmen.

- Letztes Jahr war das Metaverse das vorherrschende Gesprächsthema, doch ein Jahr später scheint künstliche Intelligenz (KI) im Mittelpunkt zu stehen. Halten Sie dies für ein vorübergehendes Phänomen oder einen echten Trend?

Es ist durchaus verständlich, einen Vergleich zwischen dem Metaverse und der künstlichen Intelligenz zu ziehen, da beide große Aufmerksamkeit und Berichterstattung in den Medien erhielten. Wir glauben jedoch, dass es sich um zwei diametral entgegengesetzte Konzepte handelt, und darin liegt die Langlebigkeit des einen gegenüber dem anderen, zumindest im Moment. Das Metaverse ist ein Konzept, das unseren physischen Raum in einen digitalen umwandelt, das Gefühl der Überbrückung von Distanzen erzeugt und versucht, digitale Beziehungen durch „optimistische“ Projektionen von uns selbst, sogenannte Avatare, zu humanisieren. Die Notwendigkeit, diese neue digitale Welt zu schaffen, wurde stark durch das durch die COVID-19-Pandemie verursachte Gefühl der Isolation befeuert, angetrieben durch bedeutende wirtschaftliche Interessen, die versuchen, bestehende „Bedürfnisse“ der realen Welt im digitalen Bereich zu reproduzieren. Zur Überraschung vieler, sowohl Einzelpersonen als auch Unternehmen, bestand die vorherrschende Reaktion nach der Pandemie darin, zum menschlichen, physischen Kontakt zurückzukehren und die in dieser Zeit eingeschränkten Naturräume wieder zu genießen, anstatt in eine digitale beobachtete Welt einzutauchen durch eine Schutzbrille. Dies markierte den Beginn des Niedergangs des Metaversums. Große Unternehmen mussten Verluste in Höhe von mehreren Millionen Dollar bei Investitionen im Zusammenhang mit Metaverse verkraften, und die Skepsis gegenüber dem Konzept selbst kam so weit, dass der führende Förderer gezwungen war, es zum Schweigen zu bringen. Genau in diesem Moment tauchte fast ohne Vorwarnung die KI auf und verbannte das Metaversum in die Vergessenheit. KI entstand als Ergebnis jahrelanger Forschung und wurde aus Gründen, die wir noch nicht als positiv oder negativ einstufen können, bereits in ihrer Entwicklungsphase für die breite Öffentlichkeit zugänglich und erzeugte eine enorme Datenmenge, die zu einem exponentiellen Wachstum führte. Ein wesentlicher Unterschied zwischen KI und dem Metaverse besteht darin, dass die Grundlage der KI Open Source ist, obwohl einige große Unternehmen ihren Erfolg darauf zurückführen, sodass jeder verschiedene KI-Modelle frei nutzen kann. Dieselbe Eigenschaft ermöglicht es Benutzern auch, Modelle zu verbessern und neue zu erstellen, was eine Geschwindigkeit und Freiheit bietet, die das Metaverse nie hatte.

Mit anderen Worten: Wenn sich das Metaverse weiterentwickeln würde, würde es wahrscheinlich auf KI-Tools angewiesen sein. Im Wesentlichen wird die technologische Grundlage eines Großteils der neuen Software durch KI geschaffen und unterstützt. Wir glauben nicht, dass dies eine vorübergehende Modeerscheinung ist; vielmehr ist es gekommen, um zu bleiben. Es kann mit dem verglichen werden, was die industrielle Revolution zu ihrer Zeit für die Welt bedeutete. Derzeit haben wir die Möglichkeit, die technologische Revolution zu erleben, die wahrscheinlich unsere Lebensweise verändern wird. In sehr kurzer Zeit wurden in verschiedenen Bereichen wie Medizin, Physik, Bildung usw. bedeutende Fortschritte erzielt, die zahlreiche Fragen im Zusammenhang mit Beschäftigung, Wirtschaft und Ethik aufwerfen.

- Haben Sie konkrete Tests mit diesen neuen Technologien durchgeführt?

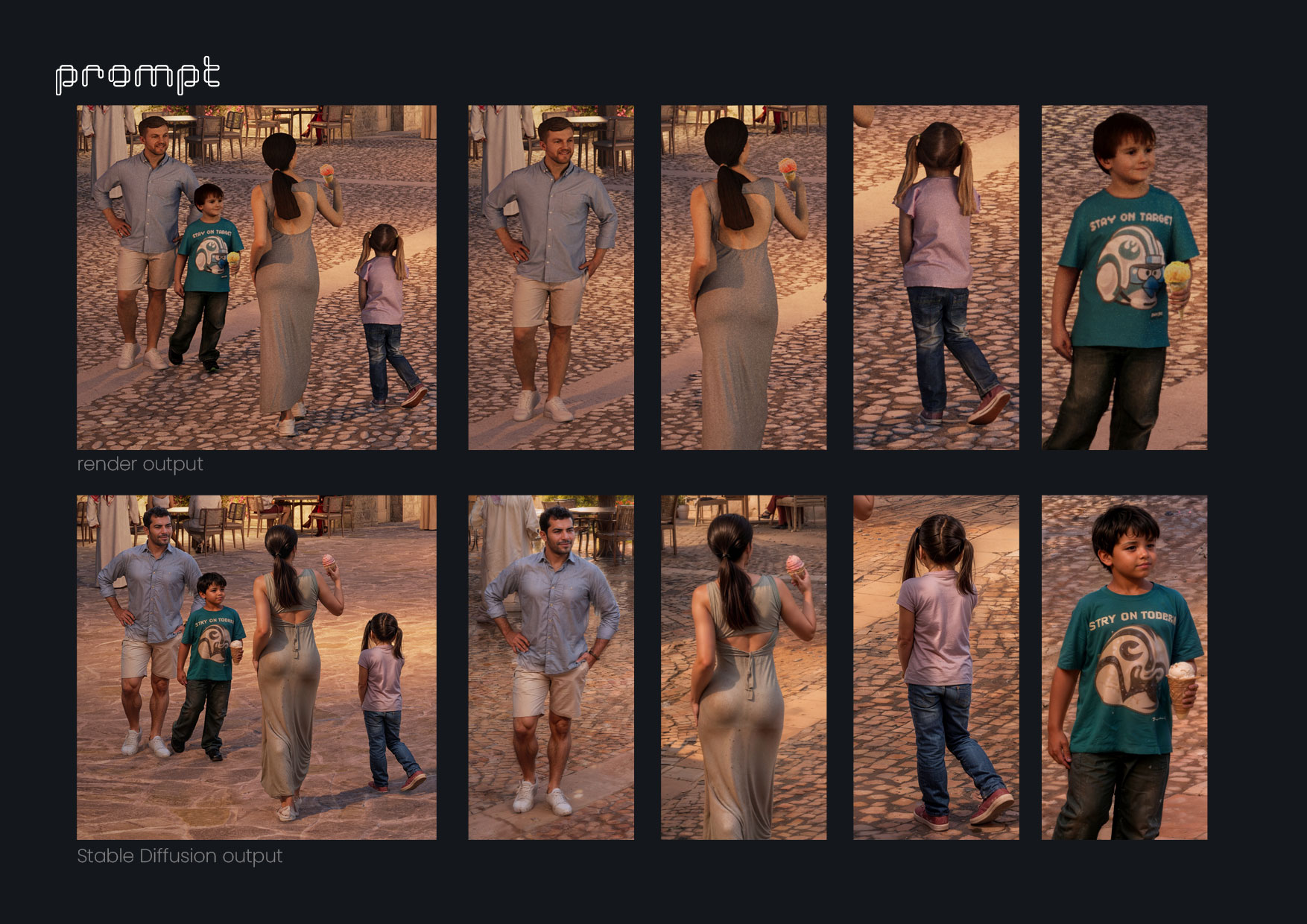

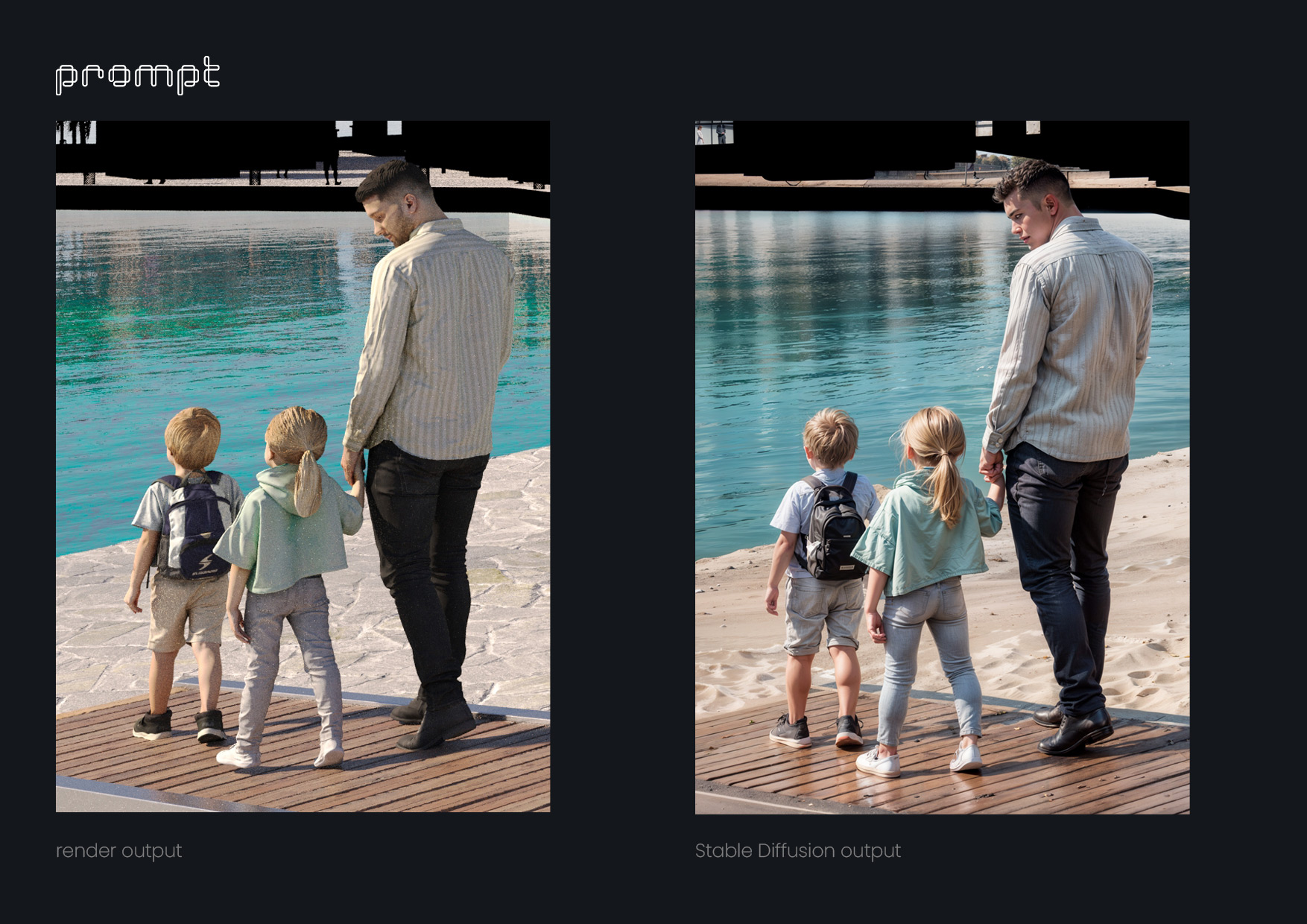

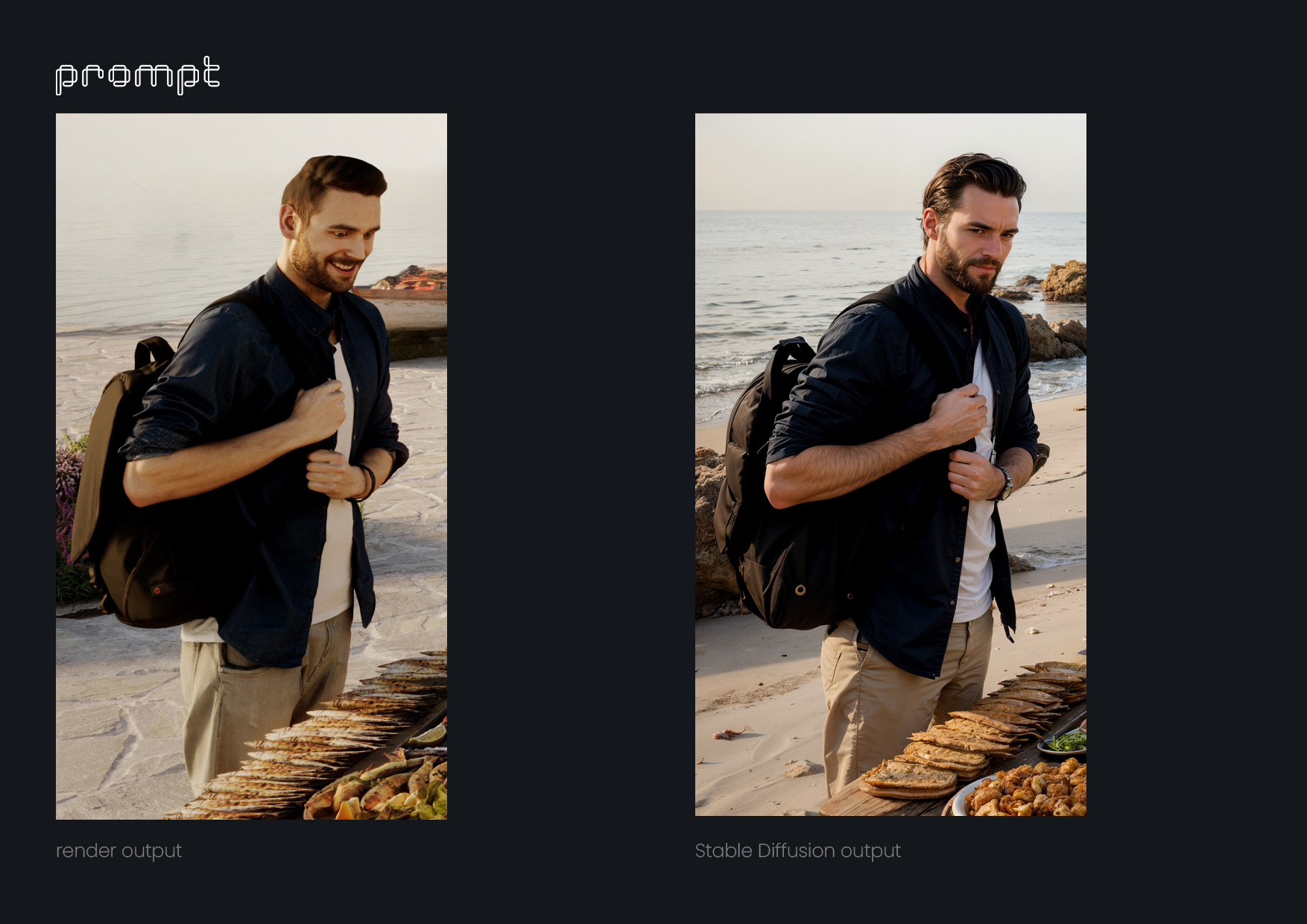

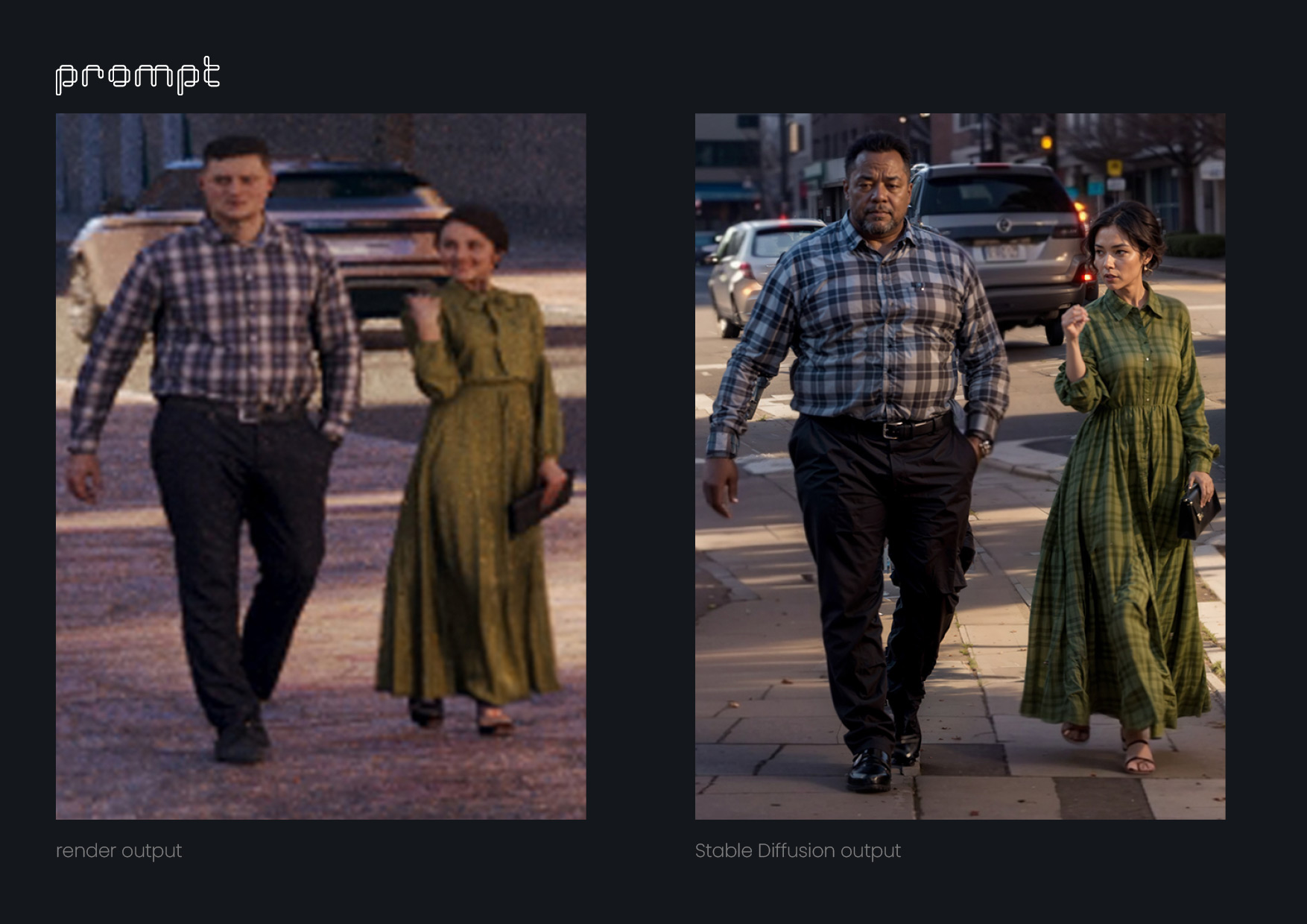

Ja, vor allem aus Neugier und dem Bedürfnis zu verstehen, wie diese neuen Werkzeuge uns bei unserer Arbeit unterstützen könnten, begannen wir fast sofort, Dall-e zu verwenden, um Rekonstruktionen von Stadtteilen in Standbildern zu erstellen. Dies war eine Aufgabe, die uns in Photoshop viel mehr Zeit gekostet hätte. Kurz darauf entstand Midjourney und wir begannen damit, erste Visualisierungen der Ideen unserer Kunden zu erstellen. Diese Bilder halfen uns dabei, die Richtung zu bestimmen, in die jedes Bild gehen sollte. Außerdem begannen wir in Midjourney mit der Entwicklung kurzer Animationseinleitungen für einige Projekte anhand von Standbildern, die wir später in After Effects animierten. Parallel dazu lernten wir durch Ausprobieren weiter, wie man das Werkzeug nutzt, das für unsere Art von Arbeit zweifellos das leistungsfähigste ist: Stable Diffusion. Damit sind wir von Animationsexperimenten zu komplexen Korrekturen in Standbildern übergegangen, haben Texturen verbessert, den Bildern organische Details hinzugefügt und sogar noch realistischere Charaktere basierend auf AXYZ anima® PRO / ALL 3D- und 4D-People-Assets erstellt. Darüber hinaus nutzten wir Sprachgenerierungsmodelle, um erste Animationsentwürfe mit Voiceovers zu erstellen, die es uns ermöglichten, diese zusammen mit dem Kunden und dem Drehbuchautor bis zur Perfektion zu verfeinern, bevor wir einen professionellen Synchronsprecher engagierten.

- Welche Ergebnisse haben Sie bisher erzielt? Handelt es sich hierbei um rein experimentelle Ergebnisse oder hatten Sie die Möglichkeit, diese in konkreten Projekten oder Dienstleistungen anzuwenden?

Da sich diese Tools ständig weiterentwickeln, gibt es noch nicht viele Informationen darüber, wie man sie effektiv nutzen kann, sodass viel Versuch und Irrtum erforderlich ist. Dadurch, dass ein Teil des Studios noch in die laufende Projektproduktion involviert war, konnte ein anderer Teil etwas Zeit der Recherche widmen. Wir sind nun an einem Punkt angelangt, an dem wir diese Erkenntnisse im gesamten Studio teilen und umsetzen können. Wir waren jedoch angenehm überrascht, wie schnell wir diese KI-Tools in reale Projekte integrieren konnten. Wir alle wissen, dass wir in unserer Branche oft mit engen Fristen arbeiten und es nicht viel Raum für Fehler gibt, geschweige denn für Experimente. Hier liegt die Bedeutung dieser neuen Tools, denn sie rationalisieren Prozesse und liefern uns Ideen und Lösungen, an die wir vorher vielleicht nie gedacht hätten, und das alles in beeindruckender Geschwindigkeit.

Es war jedoch nicht ohne Herausforderungen. Zum Beispiel haben wir ein Video erstellt, das einen neuen narrativen Ansatz für die Einführung eines Projekts beinhaltet, aber der Kunde hat uns gebeten, die gesamte Einleitung, die mithilfe von Midjourney-Bildern erstellt wurde, zu verwerfen. Sie zögerten, solche künstlich wirkenden Bilder zu zeigen, und am Ende konnten wir nicht feststellen, ob es sich dabei um eine persönliche Vorliebe oder einfach um ein mangelndes Verständnis des Tools und seiner Fähigkeiten handelte. Wir mussten alle von uns erstellten Bilder in FullHD-Qualität durch pixelige Stockvideos ersetzen. Aus diesem Grund verstehen wir, dass dies alles Teil eines Prozesses ist, sowohl in Bezug auf das Lehren als auch auf das Lernen, ähnlich wie AutoCAD in der Welt der 2D-Architekturzeichnung zunächst auf Widerstand stieß. Anfangs waren viele Menschen gegen das computergestützte Zeichnen, aber heute, mehr als 20 Jahre später, ist es eines der beliebtesten Zeichenwerkzeuge.

- Können Sie uns etwas über einen davon erzählen?

Kürzlich entwickelte einer unserer Kunden ein Projekt auf einer Insel im Roten Meer und wollte, dass das Präsentationsvideo des Projekts mehr als nur architektonisch ist; Sie wollten, dass es eine starke narrative Komponente hat. Sie schrieben uns:

Zur Einleitung des Videos müssen wir die Geschichte von Pilgern während der Migration (Hidschra 620 n. Chr.) erzählen, die bei der Überquerung des Roten Meeres in ihren charakteristischen Dhows (Booten) auf einer praktisch einsamen Insel Schiffbruch erlitten. Das wenige Holz, das sie aus den Booten bergen können, wird zum Verbrennen und Erzeugen von Rauchsignalen verwendet. Da sie jedoch nie gerettet werden, beschließen sie, sich auf der Insel niederzulassen und eine Architektur zu entwickeln, die auf Korallen, Algen, Stuck und einem Pyramidenstamm basiert Formen. Nach einigen Jahren versiegt die einzige Quelle der Insel und mit ihr verschwindet die kleine Zivilisation, sodass nur noch die Überreste dieser einzigartigen Architektur übrig bleiben. Wir müssen einen coolen Übergang schaffen, um zu vermitteln, dass 1400 Jahre vergangen sind und wir uns in der Gegenwart befinden und unseren Projektvorschlag sehen, der viele Merkmale der Architektur der Insel berücksichtigt.

Und das alles nur einen Monat vor Ablauf der Frist, wobei 16 Bilder und eine 2-minütige 3D-Animation des Projekts selbst entstanden sind ... Vor einem Jahr hätte die Antwort gelautet: „Das ist unmöglich, sonst wird es verhältnismäßig viel kosten.“ ähnlich wie „Avatar: The Sense of Water“ zu machen.“ Aber glücklicherweise konnten wir eine praktikable Lösung anbieten. Zuerst haben wir in GPT-4 einen speziellen Chat über die Hijrah-Zeit erstellt und gefragt, wie sich die Pilger kleiden könnten, welche Bräuche sie hätten, wie ihre Dhaus aussahen, welche Werkzeuge sie benutzten und so weiter. Wir haben viele Informationen gesammelt, die uns helfen würden, eine imaginäre Darstellung dieser Zeit zu erstellen. Anschließend haben wir die Anweisungen von Midjourney zu den Textaufforderungen, die zum Generieren von Bildern verwendet werden sollten, kopiert und eingefügt. Wir haben GPT-4 auch mehrere Beispiele für Eingabeaufforderungen gegeben, die fotorealistische Bilder erzeugt hatten. Mit all diesen Informationen begannen wir, GPT-4 zu bitten, Eingabeaufforderungen zum Generieren von Bildern für jeden Teil des von unserem Kunden bereitgestellten Skripts zu schreiben. Auf diese Weise haben wir eine Erzählung durch Bilder geschaffen, buchstäblich Hunderte von Bildern generiert, bevor wir eines gefunden haben, das gut funktioniert hat, und nach und nach hat sich die Erzählung zusammengefügt. Anschließend haben wir mit Photoshop Beta einige Anpassungen an den Bildern vorgenommen (auch mithilfe der neuen KI-Tools), und in After Effects haben wir einige Elemente animiert und einen Parallaxeneffekt hinzugefügt. Mit Musik, Sound und einigen anderen Effekten konnten wir eine starke erzählerische Komponente erreichen, genau wie der Kunde es wollte.

- Was ist Ihre Vision für die Zukunft? Wie verändern diese Werkzeuge Ihrer Meinung nach die Arbeit eines Künstlers oder werden sie verändern, wenn sie es noch nicht getan haben?

Wir sind der festen Überzeugung, dass sich Künstler durch diese Technologie nicht bedroht fühlen sollten. Ihre Rolle, nicht als Handwerker, sondern als Künstler, sollte darin bestehen, über die Werkzeuge hinaus zu schaffen und herauszufinden, welches der 100 in wenigen Minuten erzeugten Bilder das richtige ist und mit den anderen zusammenarbeitet. Künstler sollten die Fähigkeit haben, Quantität anzunehmen; Quantität ist zu einem weiteren Element des kreativen Prozesses geworden. Vergessen wir die Debatte zwischen „Quantität vs. Qualität“. Lasst uns die Angst verlieren, dass unser Stil uns gehört und dass diese Technologie ihn stiehlt, damit andere ihn sinnlos nutzen können. Uns wird eine unendliche Welt an Stilen geboten, die andere Stile hervorbringen wird, und denken wir daran, dass wir wahrscheinlich auf diese Weise überhaupt zu unserem Stil gekommen sind. Wir sind Spezialisten für Tools zur Bilderstellung, und dies ist nur ein weiteres Tool. Lassen Sie uns Experten für dieses Tool werden, und wir werden keine Angst davor haben, Kunden zu verlieren, denn sie werden keine Experten sein und nur an der Oberfläche dieses Tools kratzen. In gewisser Weise demokratisiert KI einen großen Teil der künstlerischen Welt, der bisher großen Produktionen mit Schauspielern, Bühnenbildern, Kameras usw. vorbehalten war. Mit einer anständigen Grafikkarte, Vorstellungskraft und Einfallsreichtum kann ein einzelner Mensch nun recht viel erreichen Ergebnisse. Und dabei handelt es sich lediglich um die Fähigkeit, eine bestehende Sprachform zu reproduzieren/nachzuahmen. Die eigentliche Herausforderung für Künstler besteht darin, eine völlig neue Sprache für die KI zu finden. Das sollte unsere einzige Sorge sein. All dies verändert sicherlich die Art und Weise, wie wir arbeiten, und wird dies auch weiterhin tun. Wichtig ist, aus professioneller Sicht zu verstehen, welches Potenzial wir mit diesen Tools erreichen können. Wir sehen, dass leistungsstarke grafische KIs die Art und Weise, wie wir digitale Inhalte präsentieren, bereits revolutioniert haben. Schon ein Blick auf eine der Social-Media-Plattformen zeigt, dass digitale Inhalte zunehmend mit KI erstellt werden.

- Schon heute sehen wir Fotobearbeitungstools, die KI-Lösungen auf bestimmte KI-Anwendungen anwenden. Glauben Sie, dass diese Technologie in Zukunft auf Rendering-Software angewendet werden könnte? Welche revolutionären Funktionen oder Fähigkeiten können Sie sich vorstellen, die diese Fusion in der Rendering-Software bieten könnte?

Angesichts der Geschwindigkeit, mit der sich diese Technologie im letzten Jahr entwickelt hat, glauben wir, dass es nur eine Frage der Zeit ist, bis sie beim Rendern von Software effektiv funktioniert. Denken Sie daran, dass es nicht nur um die visuelle/grafische Ausgabe geht, die KI generieren kann, sondern auch um ihre Fähigkeit, bei der Nutzung zu lernen und sich selbst zu verbessern und Feedback basierend auf ihrer Leistung zu erhalten. Beispielsweise könnte eine Rendering-Engine die Rendering-Zeiten deutlich verbessern, wenn sie das gleiche Rendering mehrmals mit kleinen Änderungen an den Einstellungen durchführt und die Ergebnisse aufzeichnet, um sie in ähnlichen Situationen zu wiederholen. Darüber hinaus gibt es einen grundlegenden Aspekt von KI-generierten Bildern, nämlich dass jede Generation durch einen Zufallsparameter namens „Seed“ gesteuert wird, der fest (um Ergebnisse zu reproduzieren) oder zufällig gehalten werden kann. Dieser Zufallsmodus kann Ideen generieren (für Rahmen, Beleuchtung, Texturen, Modellierung), an die der Künstler vielleicht nie gedacht hätte. Bei besonderer Aufmerksamkeit können wirklich überraschende Ergebnisse erzielt werden. Es wäre nicht abwegig zu glauben, dass Rendering-Software diese Funktionalität irgendwann im Dienste der Kreativität des Künstlers implementieren könnte. Sicherlich wird es nicht nur die Rendering-Software verbessern, sondern auch die 3D-Modellierung revolutionieren. Bisher war die 3D-Modellierung ein zeitaufwändiger Teil der digitalen Erstellung. Stellen Sie sich für einen Moment vor, dass 3D-Objekte mithilfe von Eingabeaufforderungen gezeichnet werden könnten. Insbesondere bei der Architekturmodellierung arbeiten wir mit rein geometrischen und mathematischen Werten, das heißt, sie sind messbar und präzise. Diese Werte können wahrscheinlich über Eingabeaufforderungen in eine KI-Plattform eingegeben werden. Dies würde es uns ermöglichen, langwierige, sich wiederholende Prozesse zu mechanisieren. Um ein Beispiel zu nennen: Es wäre so, als hätte man einen virtuellen 3D-Zeichenassistenten zur Hand.

- Wir beobachten, dass die meisten KI-Tools hauptsächlich über Textaufforderungen funktionieren. Da Sie jedoch Grafiker sind, wären natürliche Eingaben dann nicht Bilder, Striche oder Moodboards? Wie stehen Sie zu diesem Ansatz?

Tatsächlich verfügt die überwiegende Mehrheit der KI, die Bilder generiert, über die Fähigkeit, visuelle Eingaben zu erfassen. Tatsächlich ist es für unsere Arbeit von entscheidender Bedeutung, dass diese Erweiterungen/Optionen von verschiedenen Plattformen bereitgestellt werden. Das vielseitigste und leistungsfähigste von allen (wenn auch weniger benutzerfreundlich) ist Stable Diffusion, zu dem mehrere äußerst nützliche Erweiterungen hinzugefügt werden können:

ControlNet:

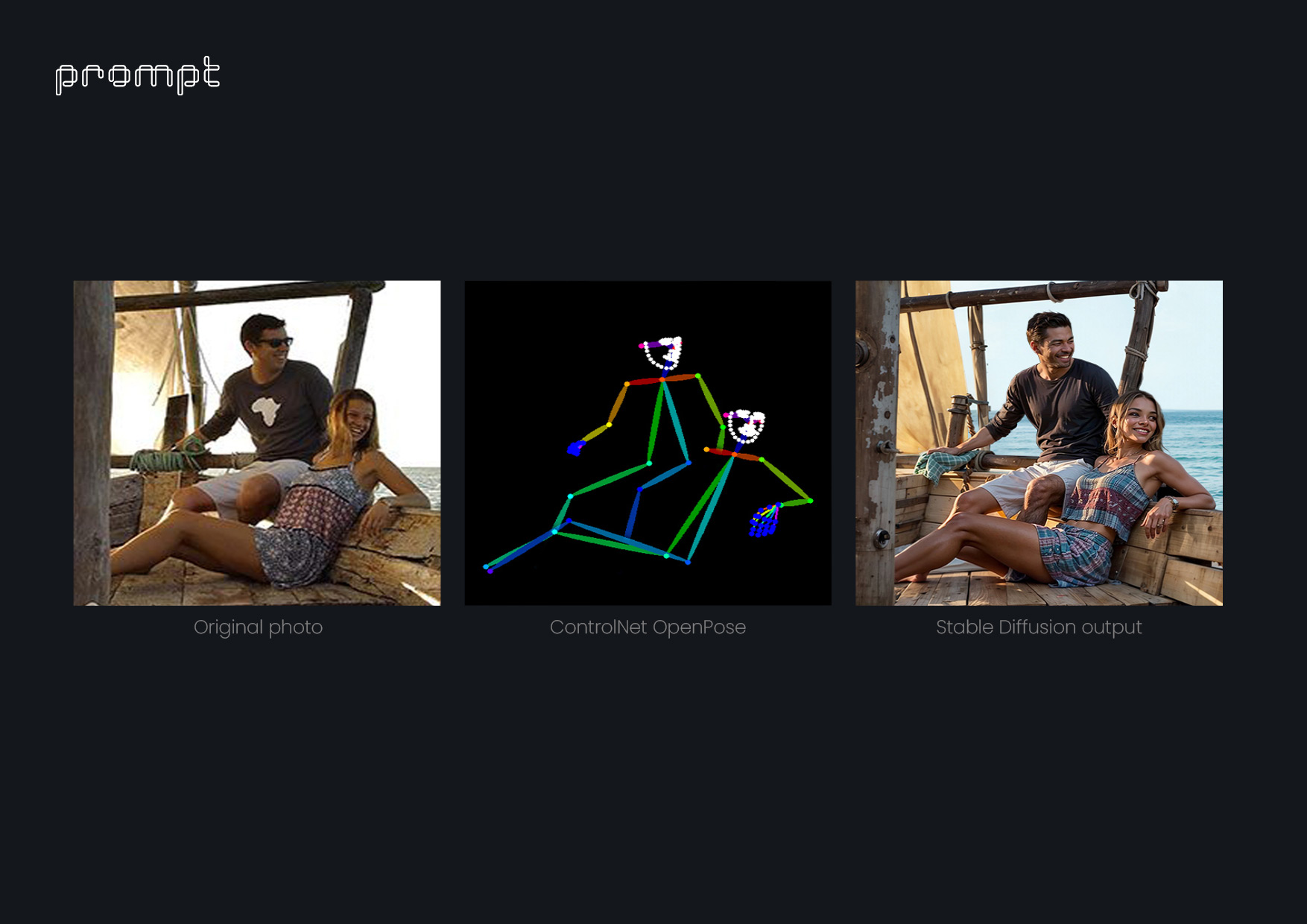

Dabei handelt es sich um eine Erweiterung, die ein vom Benutzer bereitgestelltes Bild analysiert und über viele verschiedene Erkennungsmodi verfügt. Sobald das gewünschte Element des Benutzers erkannt wurde, kann er durch Textaufforderungen angewiesen werden, nur diesen ausgewählten Teil zu ändern. Zum Beispiel:

- Der „OpenPose-Modus“ ermöglicht es uns, die Position menschlicher Figuren in Bildern (Körper, Hände, Gesichter usw.) zu bestimmen. Mit diesem Modus können wir die Position eines AXYZ anima® PRO / ALL 3D- und 4D-Personencharakters erkennen, der bereits in eine Szene integriert ist. Indem wir den Kamerawinkel und die Beleuchtung beibehalten, können wir noch realistischere Variationen derselben Figur erstellen, die dann in Photoshop weiter komponiert werden können.

- Der „Referenzmodus“ wird verwendet, um den Stil eines Bildes zu kopieren und auf ein anderes anzuwenden.

- Der „Tiefenmodus“ dient dazu, Volumina im Raum eines Bildes zu erkennen und sie dann in einem anderen Bild wiederzugeben.

- Der „Hed-Modus“ erkennt kleine Details, die die Konturen verschiedener Elemente in einem Bild bestimmen. Dies ist eine der leistungsstärksten Erweiterungen und wird dank der Beiträge der Benutzer ständig weiterentwickelt.

SD Ultimate Upscaler:

Diese Erweiterung wird zum Skalieren, Rekonstruieren und Hinzufügen von Details zu Bildern mit niedriger Auflösung verwendet. Wir alle kennen Situationen, in denen ein Kunde eine ganz bestimmte Textur anfordert und uns ein 75 x 75 Pixel großes Foto sendet, aber möchte, dass diese Textur 80 % eines 4000 Pixel großen Bildes abdeckt. Früher hätten wir Stunden damit verbracht, diese Textur zu reproduzieren. Dank dieser Erweiterung können wir jetzt genau die gleiche Textur verwenden, die der Kunde wünscht, ohne an Qualität einzubüßen.

Inpaint:

Es erlaubt nur das Zeichnen auf einem Bild, das wir mit einer Textaufforderung ändern möchten.

Outpaint:

Aus demselben Bild werden Inhalte generiert, die über die Grenzen des ursprünglichen Bildrahmens hinausgehen. Dies sind nur einige der Erweiterungen, die Benutzern zur Verfügung stehen, um Bilder ausschließlich auf der Grundlage visueller Eingaben zu erstellen. Das Wunderbare an all dem ist, dass die Entwicklung dieser Tools, da sie Open Source sind, von den Beiträgen von Benutzern und Entwicklern abhängt und nicht nur von einem Unternehmen, das nur durch wirtschaftliche Interessen motiviert ist.

- Wie stellen Sie sich mit Blick auf die Zukunft eine mögliche Weiterentwicklung Ihrer derzeitigen Arbeit vor?

Derzeit wurden bemerkenswerte Fortschritte bei der Erzeugung statischer Bilder gemacht. Die größte Herausforderung liegt jedoch in der Animation. Bis zu diesem Punkt umfasst der intrinsische Betrieb verschiedener KI-Systeme die Generierung jeweils eines Frames, was als unabhängig interpretiert wird. Dies kann zu einer gewissen Instabilität oder mangelnden Konsistenz zwischen den Bildern führen, wodurch das gesamte Bild bei der Wiedergabe etwas „verwackelt“ erscheint. Es ist wahrscheinlich, dass diese Instabilität mit der Zeit behoben wird. Wie bereits erwähnt, besteht die faszinierendste Aussicht jedoch in der Entwicklung einer visuellen Sprache, die nicht nur nachahmt, was wir bereits tun, sondern diese visuellen Inkonsistenzen und Instabilitäten berücksichtigt und sie nicht als Fehler, sondern als Tugenden betrachtet. Unsere Bestrebungen für die nahe Zukunft basieren auf der Suche nach dieser neuen Ausdrucksweise.

- Abschließend möchte ich Sie aus Ihrer Sicht als Benutzer und Künstler fragen, wie Sie sich eine zukünftige Version unseres Flaggschiffprodukts anima® PRO / ALL vorstellen.

Wenn wir es uns erlauben, über technische Komplexitäten hinauszudenken, könnten wir uns eine zukünftige Version von anima® PRO / ALL vorstellen, in der es seine umfangreiche Datenbank menschlicher Bewegungen und visueller Eingaben von Einzelpersonen (Ethnizität, Kleidung, Situationen) nutzt und diese mit ähnlichen Tools interpretiert zu OpenPose. Dieses zukünftige Anima® würde es Benutzern ermöglichen, eine Bewegung und eine physische Beschreibung einer Figur einzugeben (oder aus einer begrenzten Liste auszuwählen) und dann ein konsistentes 3D-Netz erzeugen, das in die Szene integriert werden kann. Dies würde den Benutzern eine unglaubliche kreative Freiheit bieten und jedes Projekt, ob statische Bilder oder Animationen, wirklich einzigartig machen. Wir verstehen, dass wir noch weit davon entfernt sind, so etwas zu entwickeln, aber angesichts all dessen, was wir in nur einem Jahr im Bereich der KI erlebt haben, wären wir nicht überrascht, wenn dies in naher Zukunft möglich sein würde. Obwohl wir Enthusiasten und Befürworter der KI-Entwicklung sind, sind wir auch besorgt über den möglichen Missbrauch dieser Tools, Verwendungen, die vom Tool selbst abweichen, aber dennoch gefährlich sind. Es liegt in unserer Verantwortung, KI zu erforschen und weiterzuentwickeln, aber gleichzeitig müssen wir uns Zeit nehmen, um die sozialen Auswirkungen zu verstehen, die sie mit sich bringt, und bereit sein, uns an eine Welt anzupassen, in der diese Technologie eine grundlegende Rolle spielt. Viele der Dinge, die wir in diesem Interview besprochen haben, basieren auf unseren eigenen Erfahrungen mit der Verwendung von KI in unserer Arbeit. Es ist möglich, dass wir uns in einigen unserer Überlegungen irren oder dass wir bestimmte Prozesse etwas oberflächlich erwähnt haben. Daher sind wir für ein Gespräch über diese Themen und die Beantwortung etwaiger Fragen jederzeit offen.

EINIGE BEISPIELE FÜR KI-VERBESSERTE RENDERINGS

ÜBER DEN KÜNSTLER

Das Kreativstudio ist ein etabliertes Team mit Sitz in Barcelona und über einem Jahrzehnt internationaler Erfahrung. Sie verfügen über eine vielfältige Gruppe von Fachleuten mit unterschiedlichem Hintergrund und unterschiedlicher Kultur, die eine umfassende Perspektive für kreative Prozesse bieten und maßgeschneiderte visuelle Lösungen anbieten. In der heutigen hochvisuellen globalen Landschaft, in der Bilder als universelle Sprache zur Förderung von Ideen und Projekten dienen, sind sie auf die Bereitstellung erstklassiger Renderings, Animationen, virtueller Rundgänge, Verkaufsbroschüren und Websites spezialisiert. Bei ihrem effizienten Arbeitsablauf geht es darum, die einzigartige Vision des Kunden zu erfassen, Fristen einzuhalten und umfassende, kostengünstige Optionen vorzustellen. Ihre Hauptdienstleistungen umfassen Renderings, Animationen, virtuelle Rundgänge, Verkaufsbroschüren und Websites.

Um mit ihnen in Kontakt zu treten, sehen Sie sich unten ihre Kontaktinformationen an:

https://www.promptcollective.com/contact