Auteur:AXYZ DESIGN

Date:2023-09-20

EXPLORER L’IMPACT DE L’IA

L'IA CHANGE-T-ELLE LES FLUX DE WORKFLOWS DE VISUALISATION ARCHITECTURALE ?

ENTRETIEN AVEC FRANCESCO TESTA DE PROMPT

Image réalisée par Prompt studio, en utilisant Midjourney AI.

Chaque jour, nous assistons à des avancées remarquables dans le domaine de l’intelligence artificielle, avec des solutions de plus en plus impressionnantes qui suscitent parfois l’admiration et, à l’occasion, suscitent des inquiétudes.

Chez AXYZ, en tant que développeurs de logiciels, et vous, en votre rôle d’artistes, il est naturel de se demander comment tirer le meilleur parti de ces nouvelles technologies. De quelle manière pourraient-ils enrichir nos tâches quotidiennes ? Ces technologies pourraient-elles contribuer à valoriser nos images et nos produits ? Et finalement, sont-ils accessibles à tous ?

Pour éclairer ces questions, nous avons eu le privilège d'interviewer Francesco Testa, le fondateur et esprit créatif du studio catalan Prompt. Ce studio de création est largement reconnu pour sa capacité à donner vie à des projets architecturaux grâce à des visualisations captivantes, des animations et des expériences de visites virtuelles à 360°.

Avant de continuer, permettez-moi d'exprimer notre sincère gratitude de nous avoir fourni la précieuse opportunité de nous plonger dans les projets et les travaux réalisés dans votre studio. De plus, nous sommes ravis que vous ayez accepté de participer à cette brève interview.

- L’année dernière, le sujet de conversation prédominant était le métaverse, mais un an plus tard, il semble que l’intelligence artificielle (IA) ait pris le devant de la scène. Considérez-vous qu’il s’agit d’un phénomène passager ou d’une véritable tendance ?

Il est parfaitement compréhensible de faire une comparaison entre le métaverse et l’intelligence artificielle, car les deux ont reçu une attention et une couverture médiatique significatives. Cependant, nous pensons qu’il s’agit de deux concepts diamétralement opposés, et c’est là que réside la longévité de l’un par rapport à l’autre, du moins pour le moment. Le Metaverse est un concept qui transforme notre espace physique en un espace numérique, créant le sentiment de combler les distances et tentant d'humaniser les relations numériques à travers des projections « optimistes » de nous-mêmes, connues sous le nom d'avatars. La nécessité de créer ce nouveau monde numérique a été fortement alimentée par le sentiment d’isolement provoqué par la pandémie de COVID-19, motivé par d’importants intérêts économiques cherchant à reproduire les « besoins » réels existants dans le domaine numérique. À la surprise de beaucoup, particuliers et entreprises, la réaction prédominante après la pandémie a été de revenir au contact humain et physique et de profiter à nouveau des espaces naturels qui avaient été restreints pendant cette période, plutôt que de se plonger dans un monde numérique observé. à travers des lunettes. Cela a marqué le début du déclin du Metaverse. Les grandes entreprises ont dû absorber des pertes de plusieurs millions de dollars dans les investissements liés au Metaverse, et le scepticisme est apparu quant au concept lui-même, au point que le principal promoteur a été contraint de le faire taire. Juste à ce moment-là, presque sans avertissement, l’IA a émergé et a relégué le Métaverse dans l’oubli. L’IA est née de nombreuses années de recherche et, pour des raisons que nous ne pouvons pas encore catégoriser comme positives ou négatives, elle est devenue accessible au grand public même dans sa phase de développement, générant une énorme quantité de données qui ont conduit à une croissance exponentielle. Une différence significative entre l’IA et le Metaverse est que, bien que certaines grandes entreprises lui attribuent leur succès, le fondement de l’IA est open source, permettant à chacun d’utiliser librement différents modèles d’IA. Cette même caractéristique permet également aux utilisateurs d'améliorer et de créer de nouveaux modèles, offrant une vitesse et une liberté que le Metaverse n'a jamais eues.

En d’autres termes, si le Metaverse devait continuer à se développer, il s’appuierait probablement sur des outils d’IA. Essentiellement, le fondement technologique d’une grande partie des nouveaux logiciels sera créé et pris en charge par l’IA. Nous ne pensons pas qu’il s’agisse d’une mode passagère ; au contraire, il est venu pour rester. Cela peut être comparé à ce qu’était la révolution industrielle pour le monde à son époque. Nous avons actuellement l’occasion de vivre la révolution technologique, qui va probablement changer notre façon de vivre. En très peu de temps, des avancées significatives ont été réalisées dans divers domaines comme la médecine, la physique, l’éducation, etc., générant de nombreuses questions liées à l’emploi, à l’économie et à l’éthique.

- Avez-vous réalisé des tests spécifiques utilisant ces nouvelles technologies ?

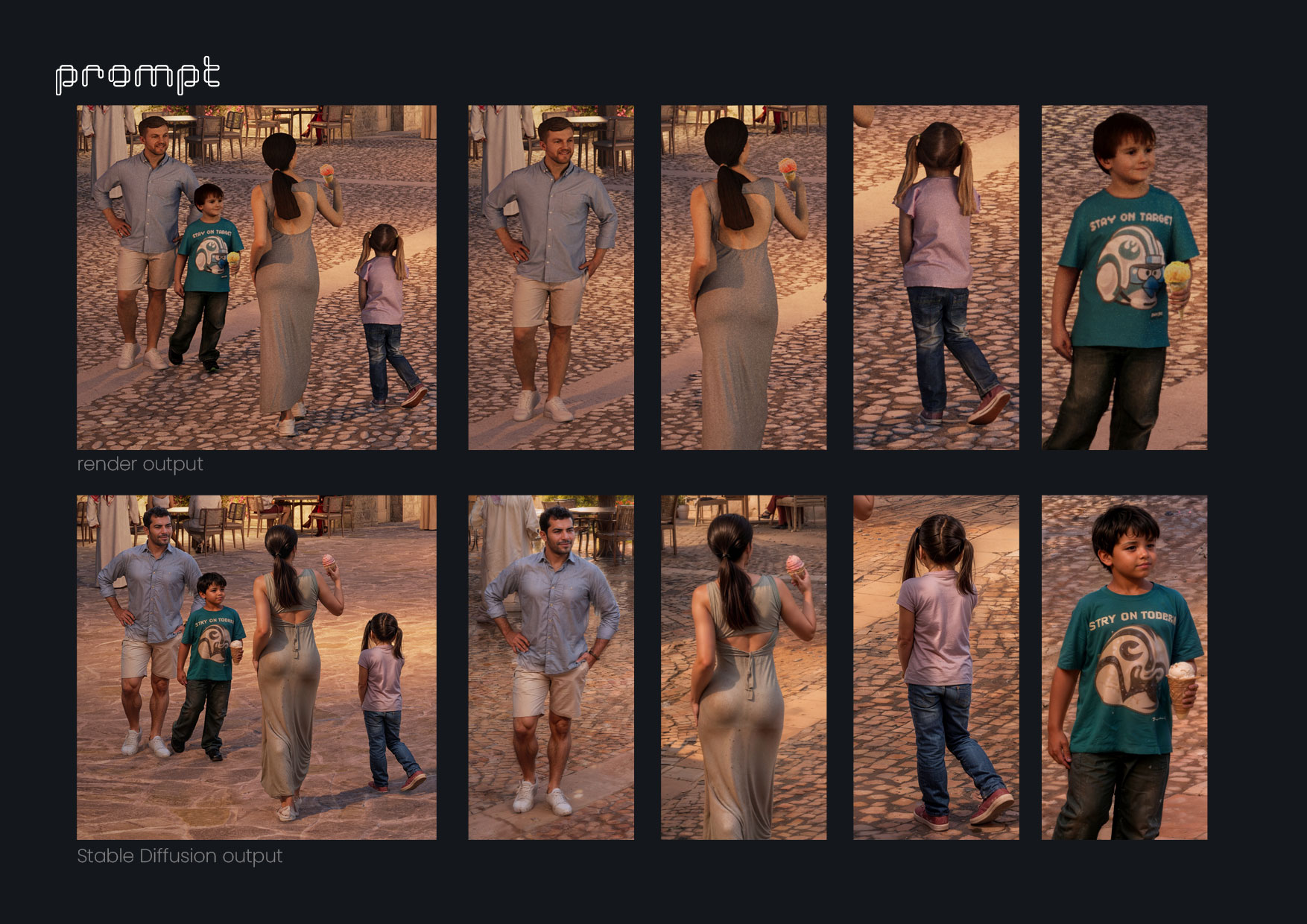

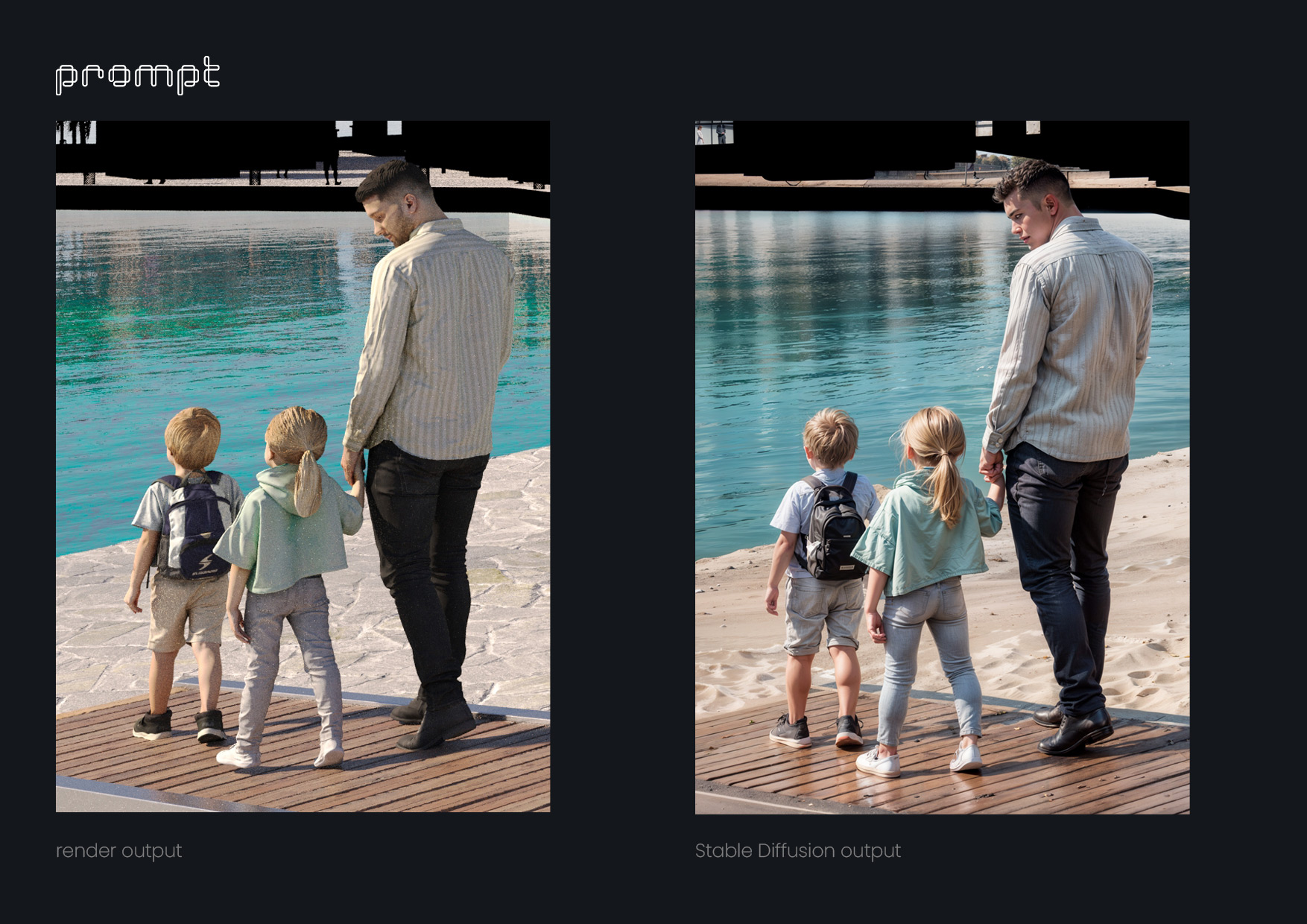

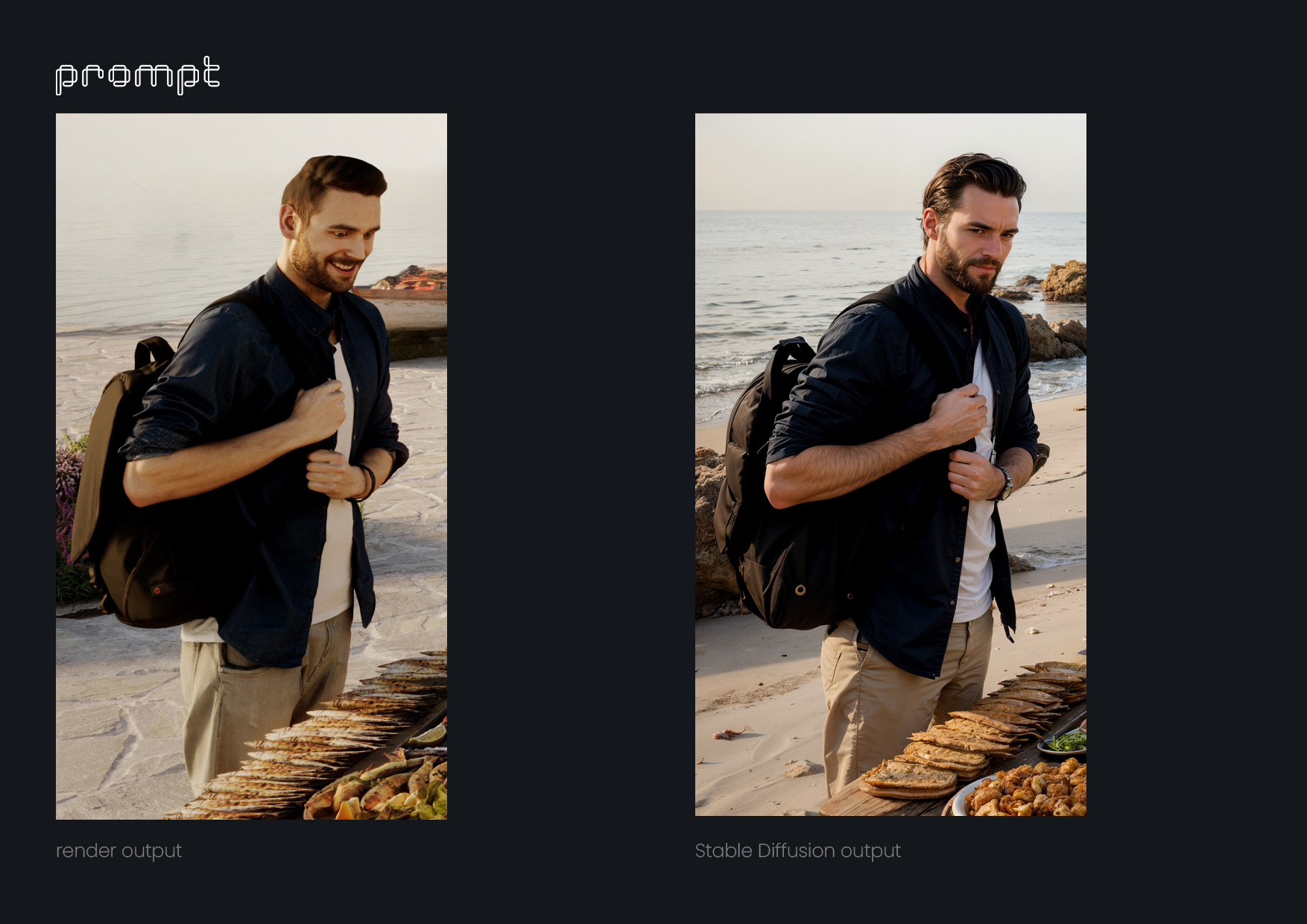

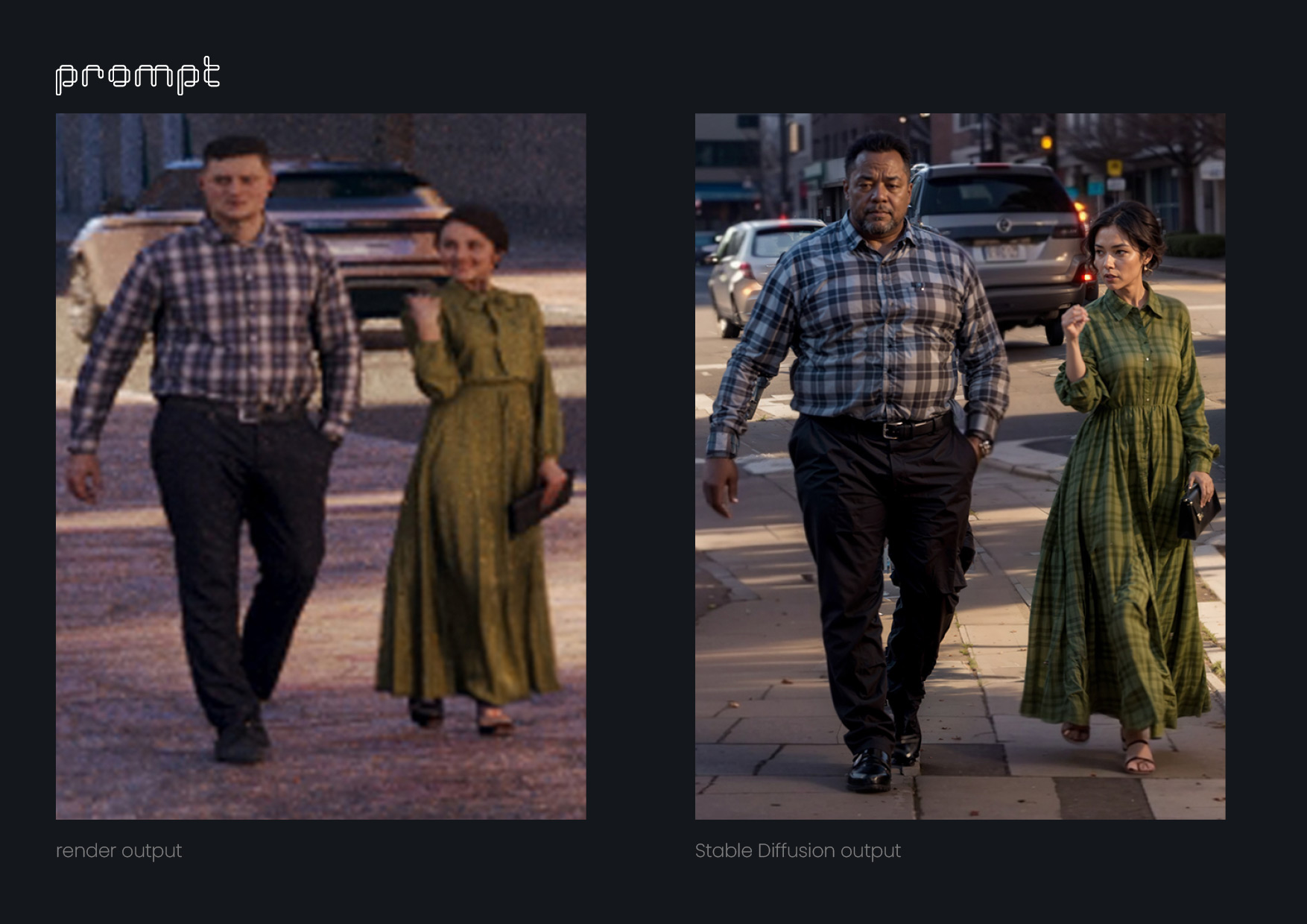

Oui, principalement motivés par la curiosité et le besoin de comprendre comment ces nouveaux outils pourraient nous aider dans notre travail, nous avons commencé à utiliser Dall-e presque immédiatement pour créer des reconstitutions de parties de villes en images fixes. C'était une tâche qui nous aurait pris beaucoup plus de temps dans Photoshop. Peu de temps après, Midjourney est apparu et nous avons commencé à l'utiliser pour réaliser les premières visualisations des idées de nos clients. Ces visuels les ont aidés à nous guider sur la direction que chaque image doit prendre. Nous avons également commencé à développer de courtes introductions aux animations pour certains projets dans Midjourney à l'aide d'images fixes, que nous avons ensuite animées dans After Effects. En parallèle, nous avons continué à apprendre à utiliser, par essais et erreurs, l'outil qui est sans doute le plus puissant pour notre type de travail : la Diffusion Stable. Grâce à lui, nous sommes passés d'expériences d'animation à des corrections complexes d'images fixes, à l'amélioration des textures, à l'ajout de détails organiques aux images et même à la création de personnages encore plus réalistes basés sur AXYZ anima® PRO / ALL 3D et 4D people. Nous avons également utilisé des modèles de génération de voix pour créer les premières ébauches d'animation avec des voix off, ce qui nous a permis de les affiner à la perfection avec le client et le scénariste avant d'embaucher un doubleur professionnel.

- Quels types de résultats avez-vous obtenus jusqu’à présent ? S’agit-il de résultats purement expérimentaux, ou avez-vous eu l’occasion de les appliquer dans des projets ou services spécifiques ?

Étant donné que ces outils évoluent continuellement, il n’existe pas encore beaucoup d’informations sur la manière de les utiliser efficacement, ce qui nécessite donc de nombreux essais et erreurs. Grâce au fait qu'une partie du studio était encore impliquée dans la production du projet en cours, une autre partie a pu consacrer du temps à la recherche. Nous avons maintenant atteint un point où nous pouvons partager et mettre en œuvre cet apprentissage dans tout le studio. Cependant, nous avons été agréablement surpris par la rapidité avec laquelle nous avons pu intégrer ces outils d'IA dans des projets réels. Nous savons tous que dans notre secteur, nous travaillons souvent avec des délais serrés et qu'il n'y a pas beaucoup de place à l'erreur, encore moins à l'expérimentation. C’est là que réside l’importance de ces nouveaux outils, car ils rationalisent les processus et nous fournissent des idées et des solutions que nous n’aurions peut-être jamais envisagées auparavant, le tout à une vitesse impressionnante.

Cependant, cela n’a pas été sans défis. Par exemple, nous avons créé une vidéo incorporant une nouvelle approche narrative pour l'introduction d'un projet, mais le client nous a demandé de supprimer l'intégralité de l'intro générée à partir des images Midjourney. Ils hésitaient à présenter des images aussi artificielles et, au final, nous n'avons pas pu déterminer s'il s'agissait d'une préférence personnelle ou simplement d'un manque de compréhension de l'outil et de ses capacités. Nous avons dû remplacer toutes les images de qualité FullHD que nous avions créées par des vidéos d'archives pixellisées. C'est pourquoi nous comprenons que tout cela fait partie d'un processus, à la fois en termes d'enseignement et d'apprentissage, similaire à la façon dont AutoCAD a initialement rencontré de la résistance dans le monde du dessin architectural 2D. Au début, beaucoup de gens étaient contre le dessin assisté par ordinateur, mais aujourd'hui, plus de 20 ans plus tard, c'est l'un des outils de dessin les plus populaires.

- Pourriez-vous nous parler de l'un d'entre eux ?

Récemment, un de nos clients développait un projet sur une île de la mer Rouge et souhaitait que la vidéo de présentation du projet soit plus que simplement architecturale ; ils voulaient qu'il ait une forte composante narrative. Ils nous ont écrit :

Pour l'introduction de la vidéo, nous devons raconter l'histoire de pèlerins lors de la migration (hégire 620 après JC) qui, en traversant la mer Rouge dans leurs boutres (bateaux) caractéristiques, ont fait naufrage sur une île pratiquement déserte. Le peu de bois qu'ils parviennent à récupérer sur les bateaux est utilisé pour brûler et créer des signaux de fumée, mais ils ne sont jamais sauvés, ils décident donc de s'installer sur l'île, développant une architecture à base de corail, d'algues, de stuc et de tronc pyramidal. formes. Au bout de quelques années, l'unique source de l'île se tarit et avec elle, la petite civilisation disparaît, ne laissant que les vestiges de cette architecture unique. Nous devons créer une transition cool pour transmettre que 1 400 ans se sont écoulés et que nous sommes aujourd'hui, en voyant notre proposition de projet, qui intègre de nombreuses caractéristiques de l'architecture de l'île.

Tout cela à peine un mois avant l'échéance, en produisant 16 images et une animation 3D de 2 minutes du projet lui-même... Il y a un an, la réponse aurait été : « C'est impossible de faire ça, ou cela coûtera proportionnellement autant que autant que faire « Avatar : Le sens de l’eau ». » Mais heureusement, nous avons pu proposer une solution viable. Ce que nous avons d'abord fait, c'est créer une discussion spécifique dans GPT-4 sur la période de l'Hégire, demandant comment les pèlerins pouvaient s'habiller, leurs coutumes, à quoi ressemblaient leurs boutres, quels outils ils utilisaient, etc. Nous avons rassemblé de nombreuses informations qui nous aideraient à créer une représentation imaginaire de cette période. Ensuite, nous avons fait un copier-coller des instructions de Midjourney concernant les invites textuelles qui doivent être utilisées pour générer des images. Nous avons également donné à GPT-4 plusieurs exemples d'invites ayant généré des images photoréalistes. Avec toutes ces informations, nous avons commencé à demander à GPT-4 d'écrire des invites pour générer des images pour chaque partie du script fourni par notre client. De cette façon, nous avons créé un récit à travers des images, générant littéralement des centaines d’images avant d’en trouver une qui fonctionnait bien, et peu à peu, le récit s’est mis en place. Ensuite, nous avons apporté quelques ajustements aux images avec Photoshop Beta (en utilisant également ses nouveaux outils d'IA), et dans After Effects, nous avons animé certains éléments et ajouté un effet de parallaxe. Avec la musique, le son et quelques autres effets, nous avons pu obtenir une forte composante narrative, exactement comme le souhaitait le client.

- Quelle est votre vision pour l’avenir ? Comment pensez-vous que ces outils transforment ou transformeront le travail d’un artiste, si ce n’est pas déjà fait ?

Nous croyons fermement que les artistes ne devraient pas se sentir menacés par cette technologie. Leur rôle, non pas d'artisans mais d'artistes, devrait être de créer au-delà des outils, de discerner laquelle des 100 images générées en quelques minutes est la bonne, celle qui fonctionne avec les autres. Les artistes devraient avoir la capacité d’accepter la quantité ; la quantité n’est devenue qu’un autre élément du processus créatif. Oublions le débat entre « quantité et qualité ». Perdons la peur que notre style nous appartient et que cette technologie le vole pour que d'autres l'utilisent sans aucun sens. On nous propose un monde infini de styles qui créeront d’autres styles, et rappelons-nous que c’est probablement ainsi que nous sommes arrivés à notre style en premier lieu. Nous sommes spécialistes des outils de création d’images, et ce n’est qu’un outil parmi d’autres. Devenons experts dans cet outil, et nous n'aurons pas peur de perdre des clients, car ils ne seront pas experts et ne feront qu'effleurer cet outil. D'une certaine manière, l'IA démocratise une grande partie du monde artistique qui était auparavant réservé aux grandes productions avec acteurs, décors, caméras, etc. Désormais, avec une carte graphique décente, de l'imagination et de l'ingéniosité, une seule personne peut réaliser de très bons résultats. résultats. Et il ne s’agit que de la capacité de reproduire/imiter une forme de langage existante. Le véritable défi pour les artistes est de trouver un nouveau langage totalement authentique pour l’IA. Cela devrait être notre seule préoccupation. Tout cela est certainement en train de transformer et continuera de transformer notre façon de travailler. L’important est de comprendre, d’un point de vue professionnel, le potentiel de ce que nous pouvons réaliser avec ces outils. Nous constatons que de puissantes IA graphiques ont déjà révolutionné la façon dont nous présentons le contenu numérique. Un simple coup d’œil sur l’une des plateformes de médias sociaux montre à quel point le contenu numérique est de plus en plus créé avec l’IA.

- Aujourd’hui, nous voyons déjà des outils de retouche photo appliquer des solutions d’IA à des applications spécifiques de l’IA. Pensez-vous qu’à l’avenir, cette technologie pourrait être appliquée aux logiciels de rendu ? Quelles fonctionnalités ou capacités révolutionnaires pouvez-vous imaginer que cette fusion pourrait offrir dans un logiciel de rendu ?

Compte tenu de la vitesse à laquelle cette technologie s'est développée au cours de la dernière année, nous pensons que ce n'est qu'une question de temps avant qu'elle ne fonctionne efficacement dans les logiciels de rendu. N'oubliez pas qu'il ne s'agit pas seulement du résultat visuel/graphique que l'IA peut générer, mais également de sa capacité à apprendre et à s'améliorer au fur et à mesure de son utilisation et de recevoir des commentaires en fonction de ses performances. Par exemple, un moteur de rendu pourrait améliorer considérablement les temps de rendu s'il effectuait le même rendu plusieurs fois avec de petites modifications dans les paramètres et enregistrait les résultats pour les répéter dans des situations similaires. De plus, il existe un aspect fondamental des images générées par l'IA, à savoir que chaque génération est régie par un paramètre aléatoire appelé « graine », qui peut être fixe (pour reproduire les résultats) ou maintenu aléatoire. Ce mode aléatoire peut générer des idées (de cadrage, d'éclairage, de textures, de modélisation) auxquelles l'artiste n'aurait peut-être jamais pensé. Si une attention particulière est portée, des résultats vraiment surprenants peuvent être obtenus. Il ne serait pas déraisonnable de penser qu'à un moment donné, un logiciel de rendu pourrait mettre en œuvre cette fonctionnalité au service de la créativité de l'artiste. Certes, cela améliorera non seulement les logiciels de rendu mais révolutionnera également la modélisation 3D. Jusqu’à présent, la modélisation 3D constituait une partie chronophage de la création numérique. Imaginez un instant si des objets 3D pouvaient être dessinés à l'aide d'invites. Surtout dans le cas de la modélisation architecturale, les valeurs avec lesquelles nous travaillons sont entièrement géométriques et mathématiques, c'est-à-dire qu'elles sont mesurables et précises. Ces valeurs peuvent probablement être saisies via des invites dans une plate-forme d'IA. Cela nous permettrait de mécaniser des processus répétitifs et fastidieux. Pour donner un exemple, ce serait comme avoir un assistant virtuel de dessin 3D à portée de main.

- Nous observons que la plupart des outils d’IA fonctionnent principalement via des invites textuelles. Cependant, puisque vous êtes graphistes, les intrants naturels ne seraient-ils pas des images, des traits ou des mood boards ? Quel est votre point de vue sur cette approche ?

En réalité, la grande majorité des IA qui génèrent des images ont intégré la capacité de prendre en compte des entrées visuelles. En fait, pour notre travail, il est crucial que ces extensions/options soient fournies par différentes plateformes. Le plus polyvalent et le plus puissant de tous (bien que moins convivial) est Stable Diffusion, auquel peuvent être ajoutées plusieurs extensions extrêmement utiles :

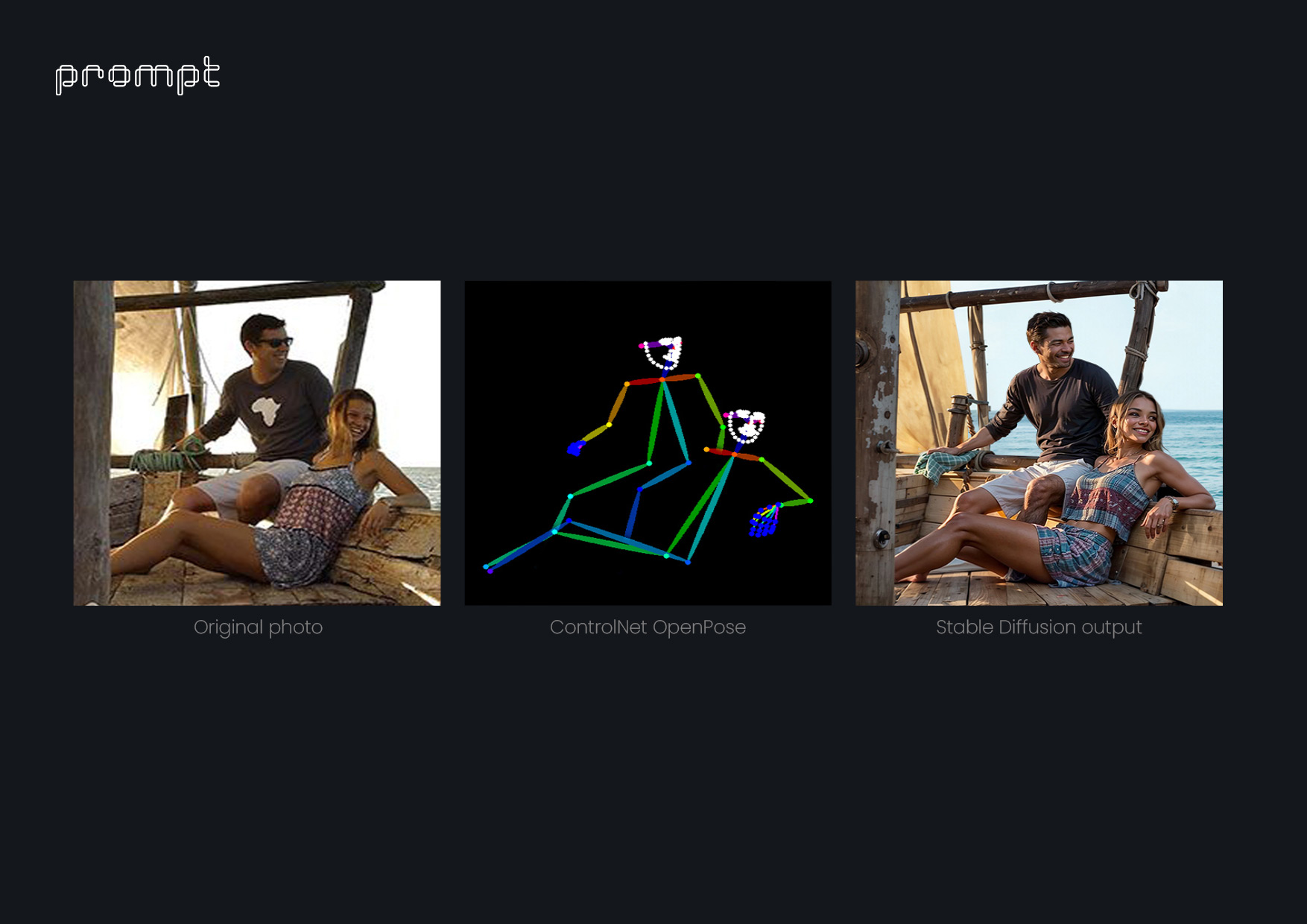

ControlNet :

C'est une extension qui analyse une image fournie par l'utilisateur et dispose de nombreux modes de détection différents. Une fois l'élément souhaité par l'utilisateur détecté, il peut lui être demandé, via des invites textuelles, de modifier uniquement la partie sélectionnée. Par exemple:

- Le « mode OpenPose » permet de déterminer la position des figures humaines dans les images (corps, mains, visages, etc.). Avec ce mode, nous pouvons détecter la position d'un personnage AXYZ anima® PRO / ALL 3D et 4D déjà intégré dans une scène. En conservant l'angle de la caméra et l'éclairage, nous pouvons créer des variations encore plus réalistes de ce même personnage, qui peuvent ensuite être composées davantage dans Photoshop.

- Le "Mode référence" permet de copier le style d'une image et de l'appliquer à une autre.

- Le « Mode profondeur » permet de détecter des volumes dans l'espace d'une image puis de les reproduire dans une autre image.

- Le « mode Hed » détecte les petits détails qui déterminent les contours des différents éléments d'une image. C'est l'une des extensions les plus puissantes et elle évolue constamment grâce aux contributions des utilisateurs.

SD Ultimate Upscaler :

Cette extension est utilisée pour redimensionner, reconstruire et ajouter des détails aux images basse résolution. Nous avons tous rencontré des situations où un client demande une texture très spécifique et nous envoie une photo de 75x75px mais souhaite que cette texture couvre 80% d'une image de 4000 px. Auparavant, nous aurions passé des heures à essayer de reproduire cette texture. Désormais, grâce à cette extension, nous pouvons utiliser exactement la même texture souhaitée par le client sans perte de qualité.

Inpaint :

Il permet de dessiner sur une image uniquement ce que l'on souhaite modifier avec une invite de texte.

Outpaint :

À partir de la même image, il génère du contenu au-delà des limites du cadre de l'image d'origine. Ce ne sont là que quelques-unes des extensions disponibles pour les utilisateurs pour créer des images basées uniquement sur des entrées visuelles. Ce qui est merveilleux dans tout cela, c'est que le développement de ces outils, étant open source, dépend des contributions des utilisateurs et des développeurs et pas uniquement d'une entreprise motivée uniquement par des intérêts économiques.

- En regardant vers l’avenir, comment envisagez-vous une évolution potentielle du travail dans lequel vous êtes actuellement engagé ?

Actuellement, des progrès remarquables ont été réalisés dans la génération d’images statiques. Cependant, le défi de taille réside dans l’animation. Jusqu’à présent, le fonctionnement intrinsèque des différents systèmes d’IA implique la génération d’une image à la fois, interprétée comme indépendante. Cela peut entraîner une certaine instabilité ou un manque de cohérence entre les images, ce qui fait que l'image entière apparaît quelque peu « tremblante » pendant la lecture. Il est probable que cette instabilité se résorbera avec le temps. Cependant, comme mentionné précédemment, la perspective la plus intrigante est le développement d'un langage visuel qui ne se contente pas d'imiter ce que nous faisons déjà, mais qui embrasse plutôt ces incohérences et instabilités visuelles, les considérant non pas comme des erreurs mais comme des vertus. Nos aspirations à court terme sont ancrées dans la poursuite de ce nouveau mode d’expression.

- En conclusion, j'aimerais vous demander, de votre point de vue d'utilisateur et d'artiste, comment envisagez-vous une future version de notre produit phare, anima® PRO / ALL ?

Si nous pouvons nous permettre de penser au-delà des complexités techniques, nous pourrions envisager une future version d' anima® PRO / ALL où il exploite sa vaste base de données de mouvements humains et d'entrées visuelles d'individus (ethnies, vêtements, situations) et les interprète à l'aide d'outils similaires. à OpenPose. Ce futur anima® permettrait aux utilisateurs de saisir (ou de sélectionner dans une liste limitée) un mouvement et une description physique d'un personnage, puis de générer un maillage 3D cohérent à intégrer dans la scène. Cela offrirait aux utilisateurs une incroyable liberté de création et rendrait chaque projet, qu'il s'agisse d'images statiques ou d'animations, véritablement unique. Nous comprenons que nous sommes encore loin de développer quelque chose comme ça, mais compte tenu de tout ce que nous avons vu en seulement un an dans le domaine de l'IA, nous ne serions pas surpris si cela devenait réalisable dans un avenir proche. Si nous sommes passionnés et promoteurs du développement de l’IA, nous sommes également préoccupés par les potentielles utilisations abusives de ces outils, des usages qui s’éloignent de l’outil lui-même mais qui n’en sont pas moins dangereux. Il est de notre responsabilité de rechercher et de continuer à développer l'IA, mais en même temps, nous devons consacrer du temps à comprendre les implications sociales qu'elle comporte et être prêts à nous adapter à un monde où cette technologie joue un rôle fondamental. La plupart des sujets abordés dans cette interview sont basés sur nos propres expériences d’utilisation de l’IA dans notre travail. Il est possible que nous nous trompions dans certaines de nos réflexions ou que nous ayons évoqué certains processus de manière quelque peu superficielle. Par conséquent, nous sommes tout à fait disposés à avoir une conversation sur ces sujets ou à répondre à toute question qui pourrait survenir.

QUELQUES EXEMPLES DE RENDUS AMÉLIORÉS PAR L'IA

À PROPOS DE L'ARTISTE

Le studio de création est une équipe établie basée à Barcelone avec plus d'une décennie d'expérience internationale. Ils disposent d'un groupe diversifié de professionnels issus d'horizons et de cultures variés, offrant une perspective complète des processus créatifs et proposant des solutions visuelles sur mesure. Dans le paysage mondial hautement visuel d'aujourd'hui, où les images servent de langage universel pour promouvoir des idées et des projets, ils se spécialisent dans la fourniture de rendus, d'animations, de visites virtuelles, de brochures commerciales et de sites Web de premier ordre. Leur flux de travail efficace consiste à saisir la vision unique du client, à respecter les délais et à présenter des options complètes et rentables. Leurs principaux services comprennent les rendus, les animations, les visites virtuelles, les brochures commerciales et les sites Web.

Pour les contacter, consultez leurs coordonnées ci-dessous :

https://www.promptcollective.com/contact